检测点

OV5640

网络工程师

IAR

beautifulsoup

WT-VL53L0 L1

Python办公自动化

计算机毕业设计

四大分析工具

训练数据

飞机大战

自媒体

django-redis

通信原理

网页作业

Starter

SAP PI接口归档

一维高斯函数

安全通告

自动控制考研

随机梯度下降

2024/4/11 23:35:52随机梯度下降法的数学基础

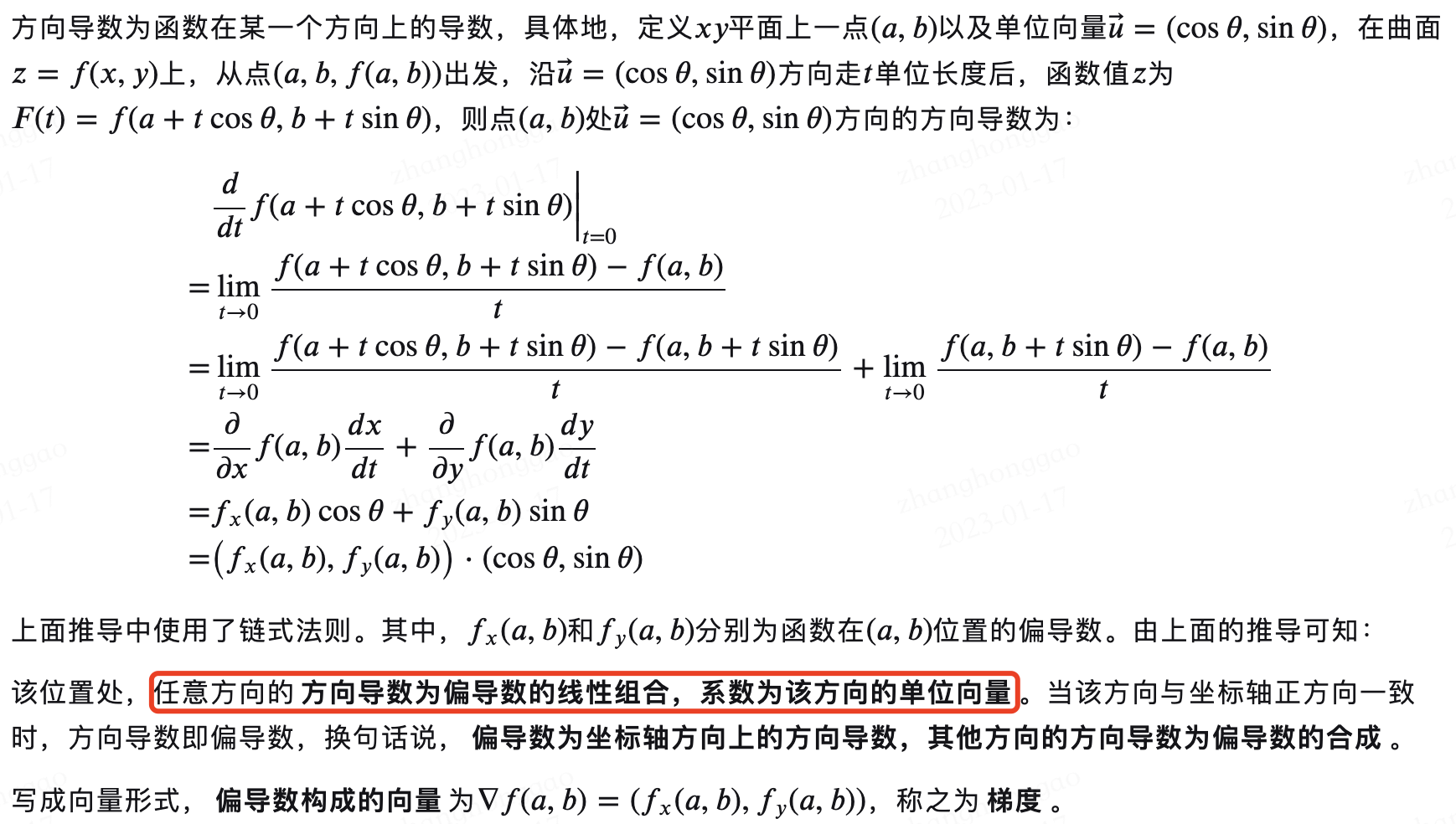

梯度是微积分中的基本概念,也是机器学习解优化问题经常使用的数学工具(梯度下降算法)。因此,有必要从头理解梯度的来源和意义。本文从导数开始讲起,讲述了导数、偏导数、方向导数和梯度的定义、意义和数学公式…

政安晨:【深度学习实践】【使用 TensorFlow 和 Keras 为结构化数据构建和训练神经网络】(三)—— 随机梯度下降

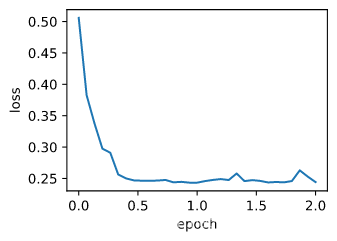

政安晨的个人主页:政安晨 欢迎 👍点赞✍评论⭐收藏 收录专栏: TensorFlow与Keras实战演绎 希望政安晨的博客能够对您有所裨益,如有不足之处,欢迎在评论区提出指正! 这篇文章中,咱们将使用Keras和TensorFlow…

批量梯度下降、随机梯度下降、小批量梯度下降

一、批量梯度下降(Batch Gradient Descent,BGD) 在批量梯度下降中,每次迭代都使用整个训练集的数据进行梯度计算和参数更新。也就是说,每次迭代都对所有的样本求取梯度,然后更新参数。由于要处理整个训练集,…

动手学深度学习之从批量归一化和残差网络、凸优化、梯度下降

参考伯禹学习平台《动手学深度学习》课程内容内容撰写的学习笔记 原文链接:https://www.boyuai.com/elites/course/cZu18YmweLv10OeV/jupyter/6X2EcSYKYpTDlzAKwQhNi 感谢伯禹平台,Datawhale,和鲸,AWS给我们提供的免费学习机会&am…

Pytorch-SGD算法解析

关注B站可以观看更多实战教学视频:肆十二-的个人空间-肆十二-个人主页-哔哩哔哩视频 (bilibili.com) SGD,即随机梯度下降(Stochastic Gradient Descent),是机器学习中用于优化目标函数的迭代方法,特别是在处…

梯度下降法几个注意点

梯度下降法中是同时更新的θ0和θ1: 同时更新θ0和θ1与不同时更新的区别如下: 同时更新是最自然的方法。 如图所示,如果同时更新与不同时更新两者是有区别的,同时更新时,两者都是在初始值得到的J的基础上进行更新&…